Cada año, el Día de la Informática nos invita a detenernos un momento para mirar con perspectiva una de las fuerzas más transformadoras de nuestro tiempo. No se trata solo de celebrar ordenadores, programas o avances tecnológicos, sino de reconocer el papel fundamental que la informática ha jugado —y sigue jugando— en la construcción de la sociedad actual. Una disciplina que nació entre laboratorios, matemáticos y científicos, y que hoy atraviesa silenciosamente casi todos los aspectos de nuestra vida.

Durante mucho tiempo, la informática fue algo casi invisible para la mayoría. Estaba “detrás” de los sistemas, de las máquinas, de los procesos industriales o científicos. Hoy, en cambio, se ha vuelto totalmente imprescindible. Está en el móvil que desbloqueamos al despertar, en las aplicaciones que usamos para trabajar, en la música que escuchamos, en los pagos que realizamos, en los mapas que nos guían y en las plataformas donde nos comunicamos. No siempre la vemos, pero siempre está ahí.

Vivimos rodeados de código, algoritmos y sistemas que funcionan de forma casi mágica para el usuario. Pedimos comida desde una aplicación, enviamos un mensaje al otro lado del mundo en segundos o almacenamos recuerdos en la nube sin preguntarnos demasiado cómo es posible. Precisamente por eso, el Día de la Informática es una buena oportunidad para hacer visible lo invisible, para recordar de dónde venimos y para comprender mejor el presente digital que habitamos.

El origen histórico de la informática

Aunque hoy asociamos la informática a pantallas, software e internet, su origen es mucho más antiguo de lo que solemos imaginar. Todo comienza con una necesidad muy humana: calcular mejor, más rápido y con menos errores. Durante siglos, los cálculos se realizaron a mano, apoyados en ábacos, reglas y sistemas matemáticos cada vez más sofisticados. Pero el verdadero salto llegó con los primeros intentos de mecanizar el pensamiento.

En el siglo XIX aparecen las primeras máquinas de cálculo mecánico avanzadas. Destaca especialmente Charles Babbage, un matemático, quien diseñó la llamada “máquina analítica”, considerada el antecedente conceptual del ordenador moderno. A su lado, Ada Lovelace, también una matemática, escribió los primeros algoritmos pensados para ser ejecutados por una máquina, convirtiéndose así en la primera programadora de la historia. En aquel momento aún no existían ni la electricidad ni los ordenadores como los conocemos, pero ya estaba sembrada la idea clave: una máquina podía seguir instrucciones lógicas.

El verdadero nacimiento de la computación moderna llega en el siglo XX, impulsado por una combinación decisiva de guerra, ciencia y universidad. Durante la Segunda Guerra Mundial, la necesidad de descifrar códigos, calcular trayectorias balísticas y optimizar recursos acelera el desarrollo de máquinas electrónicas capaces de procesar información a gran velocidad.

En ese contexto destaca de forma decisiva la figura de Alan Mathison Turing, matemático británico considerado uno de los padres de la informática moderna. Su trabajo en el descifrado de los códigos de la máquina Enigma utilizada por el ejército alemán fue clave para el desarrollo del conflicto y, según numerosos historiadores, contribuyó a acortar la guerra y a salvar millones de vidas. Más allá de su labor en criptografía, Turing formuló el concepto de la “máquina universal”, base teórica de todos los ordenadores actuales, y dejó planteada una de las grandes preguntas del siglo XX: ¿pueden las máquinas pensar?

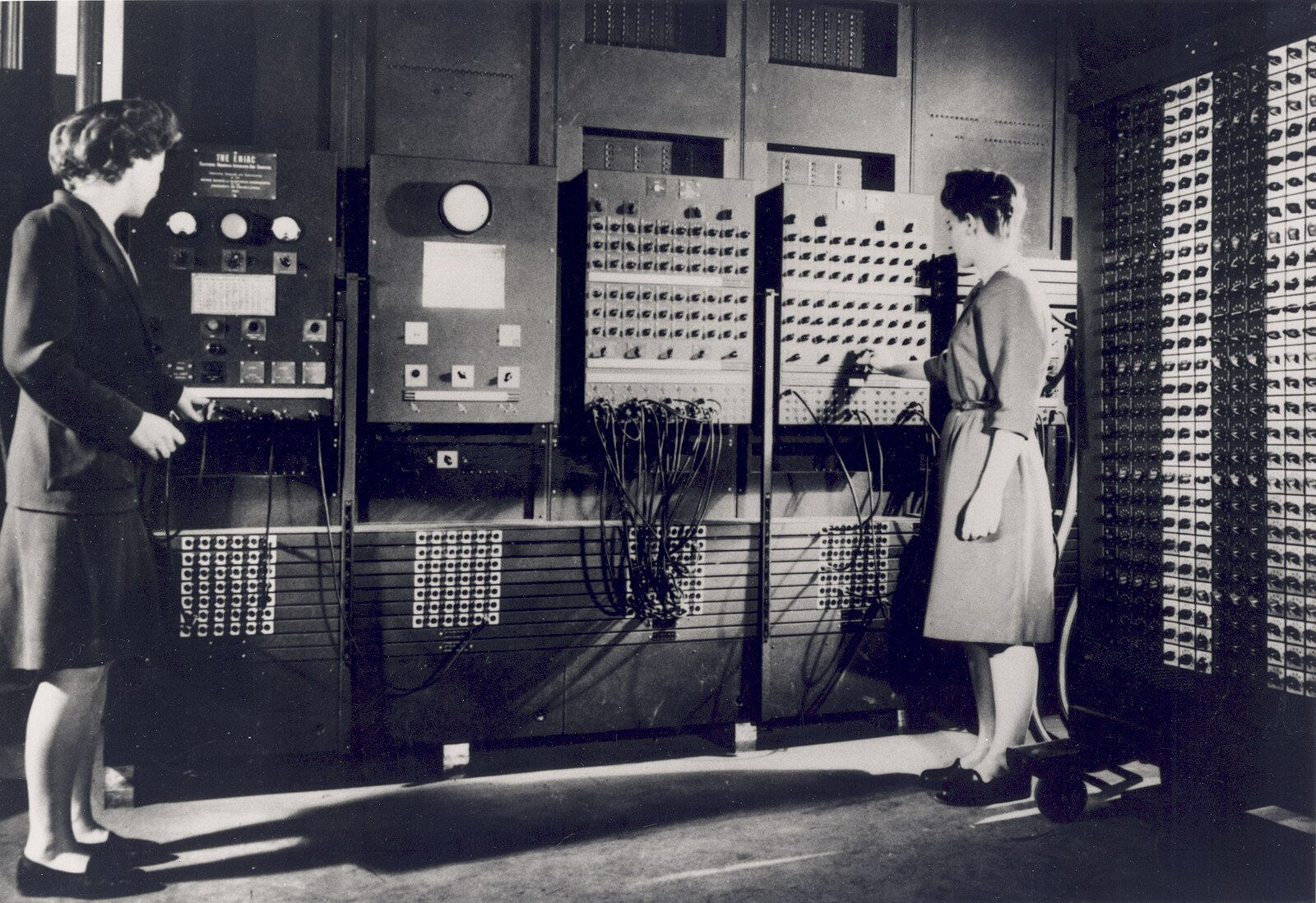

En paralelo, surgen los primeros grandes ordenadores electrónicos de propósito general, como ENIAC, aquellas enormes máquinas que ocupaban salas enteras y consumían cantidades descomunales de energía, pero que demostraban algo revolucionario: una máquina podía ejecutar miles de cálculos por segundo.

Tras la guerra, la informática se consolida en universidades y centros de investigación. La ciencia necesita simulaciones, cálculos complejos y tratamiento masivo de datos. Paralelamente, las grandes empresas empiezan a ver su potencial para la gestión, la contabilidad y la automatización de procesos. Nace así la informática como disciplina académica y como herramienta estratégica, tanto en el ámbito científico como en el empresarial.

El siguiente gran salto llega con la aparición de los ordenadores personales a finales de los años setenta y principios de los ochenta. Empresas como IBM o Apple llevan la informática fuera de los laboratorios y las grandes corporaciones, y la colocan en casas, oficinas y escuelas. El ordenador deja de ser una máquina inaccesible para convertirse en una herramienta cotidiana. A partir de ese momento, la informática ya no solo sirve para calcular, sino para crear, comunicar, diseñar, jugar y trabajar.

En todo este proceso se produce un cambio fundamental: se pasa del simple “cálculo” al software. Ya no se trata solo de hacer operaciones numéricas, sino de crear programas que controlan procesos, toman decisiones, interactúan con personas y gestionan información. El corazón de la informática deja de ser la máquina y pasa a ser el código, ese lenguaje invisible que permite que todo funcione.

Así, en apenas unas décadas, la informática evoluciona desde engranajes mecánicos hasta sistemas digitales capaces de simular inteligencia, anticipar comportamientos y conectar a millones de personas en tiempo real. Un recorrido vertiginoso que explica por qué hoy resulta casi imposible imaginar el mundo sin ella.

¿Por qué se celebra el Día de la Informática?

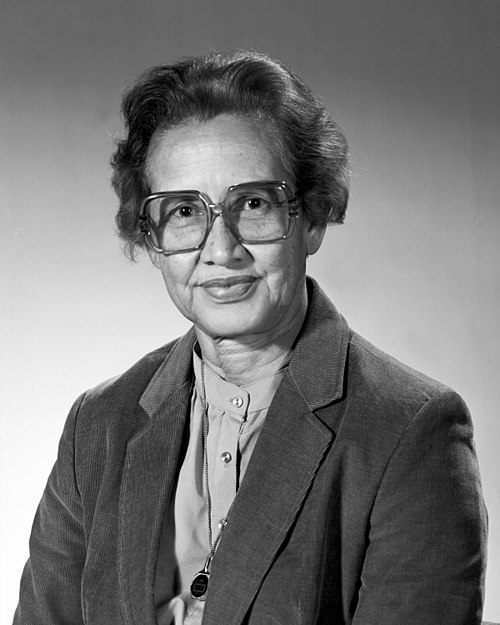

El Día de la Informática no surge como una fecha comercial ni como una celebración vinculada a una marca o a un producto concreto. Su origen está ligado al deseo de reconocer una disciplina que ha transformado profundamente la forma en que funciona el mundo. En muchos países, como en España, esta jornada se asocia al 9 de diciembre, fecha que homenajea el nacimiento de una de las grandes pioneras de la computación moderna, Grace Hopper, científica, matemática y referente clave en el desarrollo de los primeros lenguajes de programación.

Pero más allá de una fecha concreta, lo importante es lo que se conmemora realmente. El Día de la Informática no celebra solo ordenadores, pantallas o dispositivos. Celebra una forma de pensar, una manera de abordar los problemas, de traducir la realidad en datos, estructuras lógicas y procesos automáticos. Celebra a todas las personas que, desde distintos ámbitos, han hecho posible que hoy vivamos en un entorno digital conectado, eficiente y, al mismo tiempo, lleno de nuevos retos.

La informática ha hecho posible avances que hoy damos por sentados: desde la gestión de millones de datos en segundos hasta la comunicación instantánea a escala global. Está en la medicina, en la educación, en la industria, en la ciencia, en la cultura, en la economía y, por supuesto, en el marketing y la comunicación. Por eso, esta jornada es también una oportunidad para tomar conciencia de su impacto social, no solo tecnológico.

Además, la informática es una disciplina profundamente híbrida. No pertenece en exclusiva a ningún campo cerrado. En ella confluyen las matemáticas, que aportan el lenguaje formal; la lógica, que estructura los razonamientos; la ingeniería, que construye sistemas fiables; y la creatividad, que imagina nuevas soluciones, nuevas interfaces y nuevas experiencias. Programar no es solo ejecutar instrucciones: es también crear, diseñar, prever y resolver.

Celebrar el Día de la Informática es, en el fondo, celebrar esa alianza entre ciencia y creatividad que sostiene silenciosamente nuestro presente digital.

Curiosidades que marcaron la historia

Más allá de los grandes hitos técnicos, la historia de la informática está llena de pequeñas anécdotas y detalles curiosos que ayudan a entender mejor cómo hemos llegado hasta aquí. Algunas de ellas parecen casi sacadas de una novela, pero forman parte real del ADN del mundo digital.

Una de las más conocidas es el origen de la palabra “bug”, que hoy utilizamos para referirnos a errores en programas. Se dice que su significado es literal: en 1947, un insecto real quedó atrapado dentro de un sistema informático, provocando un fallo inesperado. El incidente fue documentado por el equipo de Grace Hopper, y desde entonces el término quedó ligado al mundo del software para siempre.

También resulta curioso el origen del término “hacker”. En su sentido original no tenía ninguna connotación delictiva ni negativa. Definía a personas con una gran pasión por la informática, capaces de comprender los sistemas a fondo, experimentar con ellos y mejorarlos. Con el paso del tiempo, el cine, los medios y los problemas de ciberseguridad fueron transformando su significado hasta el uso actual.

Otra historia llamativa es la de internet, que no nació como un proyecto civil ni comercial, sino con fines militares y científicos. Su antecesor, ARPANET, buscaba asegurar las comunicaciones incluso en situaciones extremas. Lo que empezó como una red experimental acabaría convirtiéndose en la infraestructura que sostiene hoy la comunicación global.

El ritmo de crecimiento de la potencia informática también ha sido objeto de asombro durante décadas. La conocida Ley de Moore, formulada por Gordon Moore, anticipó que la capacidad de los procesadores se duplicaría aproximadamente cada dos años. Durante mucho tiempo, esta predicción se cumplió con una precisión sorprendente, explicando por qué cada generación de tecnología parecía dejar obsoleta a la anterior en muy poco tiempo.

Y si hay una transformación especialmente impactante es la del almacenamiento de la información. En los primeros años, guardar datos requería soportes físicos pesados, voluminosos y muy limitados. Hoy, millones de personas almacenan su vida digital —fotos, vídeos, documentos, recuerdos— en algo tan aparentemente etéreo como la nube. En apenas unas décadas, hemos pasado de conservar la información en objetos físicos a confiarla a una red global de servidores invisibles.

Incluso el correo electrónico, hoy tan cotidiano, fue en su momento una auténtica revolución. El primer mensaje se envió en 1971, y su creador eligió el símbolo @ casi por azar para separar al usuario del sistema. Aquella decisión improvisada acabaría convirtiéndose en uno de los iconos universales de la era digital.

Estas curiosidades, lejos de ser simples anécdotas, nos recuerdan que la informática no solo avanza a través de grandes inventos, sino también mediante decisiones humanas, errores improvisados y pequeños hallazgos que, con el tiempo, cambian el mundo.

La mujer en la informática

Aunque hoy la informática se percibe a menudo como un entorno mayoritariamente masculino, sus orígenes están profundamente marcados por el trabajo de mujeres. De hecho, como hemos visto antes, el primer algoritmo de la historia fue escrito por una mujer, Ada Lovelace, en pleno siglo XIX. También hemos visto que una de las grandes figuras del desarrollo del software moderno fue Grace Hopper, quien sentó las bases de los lenguajes de programación y popularizó conceptos que seguimos utilizando hoy.

Durante las primeras décadas de la computación, programar era considerado una tarea secundaria, casi administrativa, y por eso fue desempeñada mayoritariamente por mujeres. Muchas de las primeras programadoras trabajaron en proyectos militares, científicos y espaciales sin recibir el reconocimiento público que sí obtuvieron sus compañeros varones. Un ejemplo emblemático es el del equipo de mujeres que programó los sistemas de cálculo de la NASA en los años 60, fundamentales para que el ser humano llegara a la Luna.

Con la llegada del ordenador personal y la informática como producto de consumo en los años 80, se produjo un giro cultural: la tecnología pasó a asociarse socialmente con el mundo masculino. A partir de ese momento, la presencia femenina en estudios y profesiones tecnológicas empezó a descender de forma progresiva, una tendencia cuyas consecuencias todavía se arrastran hoy.

Sin embargo, las mujeres nunca han dejado de estar presentes en la informática. Desde campos tan diversos como la criptografía, la programación, la inteligencia artificial, la ciberseguridad o el diseño de sistemas, su aportación ha sido —y sigue siendo— esencial. Hoy, cada vez más iniciativas educativas, sociales y empresariales trabajan para romper estereotipos, fomentar vocaciones tecnológicas y recuperar referentes femeninos que durante años fueron invisibilizados.

Hablar del papel de la mujer en la informática no es solo una cuestión de justicia histórica. Es también una cuestión de futuro. La tecnología que estamos construyendo moldea la sociedad en la que viviremos. Y cuanto más diversa, plural e inclusiva sea la mirada desde la que se diseña, más humana, justa y equilibrada podrá llegar a ser.

De la informática al mundo digital actual

Todo lo que hoy llamamos “mundo digital” tiene una base común: la informática. Sin ella, ninguno de los grandes hitos tecnológicos que forman parte de nuestra vida cotidiana habría sido posible. Lo que empezó como una herramienta para automatizar cálculos terminó convirtiéndose en la infraestructura invisible que sostiene nuestra forma de comunicarnos, trabajar, informarnos y relacionarnos.

Uno de los mayores saltos fue la llegada de Internet. La capacidad de conectar ordenadores entre sí a escala global transformó para siempre el acceso a la información, la educación, el comercio y la comunicación. Internet no solo acortó distancias: cambió nuestra percepción del tiempo, del espacio y de la inmediatez. Hoy convivimos con la idea de estar permanentemente conectados como algo natural, pero detrás de esa normalidad hay décadas de desarrollo informático.

Los smartphones llevaron esa conexión un paso más allá. El ordenador dejó de estar sobre una mesa para vivir en el bolsillo. Estos dispositivos no son solo teléfonos: son cámaras, agendas, mapas, billeteras digitales, reproductores de música, centros de trabajo y herramientas de comunicación global. Todo eso es posible gracias a sistemas operativos, aplicaciones, redes y millones de líneas de código funcionando de forma coordinada.

A partir de ahí, la conexión dejó de ser exclusiva de las personas para extenderse también a los objetos. El llamado Internet de las Cosas (IoT) ha permitido que electrodomésticos, coches, relojes, sensores urbanos, fábricas o sistemas de riego estén conectados a la red, intercambien datos y tomen decisiones automáticas. La informática ya no solo vive en los dispositivos que usamos, sino también en los entornos que habitamos.

Las redes sociales transformaron después la manera en que nos relacionamos. Ya no solo consumimos información, sino que la producimos, la compartimos y la comentamos en tiempo real. La comunicación se volvió inmediata, pública y global. La informática hizo posible estas plataformas, pero también abrió debates sobre identidad digital, exposición pública, desinformación y dependencia tecnológica.

Más recientemente, la inteligencia artificial ha puesto sobre la mesa un nuevo cambio de paradigma. Sistemas capaces de aprender, generar imágenes, textos, música o tomar decisiones están redefiniendo sectores como la medicina, la industria, la educación, la creación de contenidos y el marketing. Lo que antes parecía exclusivo de la ciencia ficción hoy forma parte de herramientas de uso cotidiano.

En todos estos avances hay un elemento común que casi nunca vemos: el código. Millones de instrucciones invisibles que hacen posible que una aplicación funcione, que una red sea estable, que un pago se procese, que una ruta se calcule o que un algoritmo recomiende contenidos. El usuario interactúa con interfaces, diseños y pantallas, pero detrás de cada gesto hay procesos informáticos complejos ejecutándose en segundos.

La informática, en este sentido, se ha convertido en la arquitectura invisible de nuestro presente. Sostiene procesos críticos sin hacerse notar. Funciona cuando todo va bien y solo llama la atención cuando algo falla. Y precisamente por eso, aunque no siempre la percibimos, está presente en prácticamente cada aspecto de nuestra vida diaria.

La informática hoy

La informática vive hoy uno de los momentos más intensos y decisivos de su historia. Nunca antes había estado tan integrada en los procesos productivos, en la vida cotidiana y en la toma de decisiones. La automatización, el uso masivo de datos, los algoritmos y el desarrollo acelerado de la inteligencia artificial están transformando sectores enteros a una velocidad sin precedentes.

En el ámbito laboral, la informática ha abierto un enorme abanico de oportunidades profesionales. Nuevos perfiles técnicos conviven con profesiones híbridas que combinan tecnología, creatividad, análisis de datos, comunicación y diseño. También ha permitido el trabajo en remoto, la colaboración global en tiempo real y el acceso a recursos formativos que antes estaban reservados a unos pocos. A nivel social y creativo, la tecnología ha democratizado la producción de contenidos, ha dado voz a millones de personas y ha facilitado nuevas formas de emprendimiento.

Sin embargo, este avance no está exento de sombras. Uno de los grandes retos actuales es el de la privacidad. Vivimos en una economía basada en los datos, donde cada acción digital deja rastro. Qué información se recoge, quién la gestiona y con qué fines se utiliza son preguntas que ya no pertenecen solo al ámbito técnico, sino también al ético y al político.

Otro desafío creciente es la dependencia tecnológica. Muchas actividades básicas de la vida diaria —trabajar, comunicarnos, informarnos, pagar, movernos— dependen hoy de sistemas informáticos. Cuando estos fallan, se paralizan servicios esenciales. Además, el uso intensivo de la tecnología plantea interrogantes sobre nuestra atención, nuestra capacidad de concentración y nuestra relación con el tiempo.

A todo ello se suma el problema de los sesgos algorítmicos. Los sistemas informáticos no son neutrales: aprenden de datos creados por personas y sociedades imperfectas. Si esos datos contienen prejuicios, desigualdades o discriminaciones, los algoritmos pueden amplificarlos de forma automática y a gran escala. Por eso, hoy más que nunca, programar no es solo un acto técnico, sino también un acto con consecuencias sociales.

La informática actual se mueve, así, en una tensión constante entre potencial transformador y responsabilidad ética. Nunca había ofrecido tantas posibilidades para mejorar la vida de las personas, pero tampoco había planteado tantos dilemas sobre cómo y para qué se debe utilizar.

La informática como lenguaje del futuro

Durante mucho tiempo, aprender informática significaba, sobre todo, aprender a usar herramientas: un programa de texto, una hoja de cálculo, un sistema operativo. Hoy, sin embargo, la informática empieza a entenderse como algo más profundo: una forma de pensar y de interpretar la realidad.

Hablar de “pensamiento computacional” no significa convertirse en programador, sino aprender a descomponer problemas complejos en partes más pequeñas, a identificar patrones, a crear pasos lógicos para resolver situaciones y a evaluar resultados. Este modo de razonar ya se está incorporando en la educación de muchos países como una competencia básica, al nivel de la lectura, la escritura o las matemáticas.

En este contexto, programar empieza a verse como una nueva forma de alfabetización. No todas las personas necesitarán desarrollar aplicaciones o escribir código profesionalmente, pero comprender cómo funcionan los sistemas digitales, qué hay detrás de una aplicación o cómo se toman ciertas decisiones automatizadas será cada vez más esencial para participar de forma plena en la sociedad. Entender el código es, en gran medida, entender el mundo digital que habitamos.

Además, la informática ya no se limita al ámbito técnico. Se cruza con el arte, la comunicación, la educación, la ciencia, la medicina, el marketing y casi cualquier disciplina imaginable. Esto la convierte en un lenguaje transversal, capaz de conectar campos muy distintos entre sí y de generar nuevas formas de expresión, creación y conocimiento.

Por eso, la informática del futuro no será solo una colección de herramientas cada vez más potentes. Será, sobre todo, una lente a través de la cual comprender la realidad, una manera de estructurar el pensamiento, de abordar los problemas y de imaginar soluciones en un mundo cada vez más interconectado, automatizado y cambiante. Hoy, además, vivimos un punto de inflexión: las herramientas de inteligencia artificial permiten que cualquier persona pueda generar código, aplicaciones o sistemas complejos a partir de simples instrucciones en lenguaje natural, entienda o no de programación. Esto no elimina la importancia del conocimiento informático, pero sí transforma radicalmente quién puede crear, cómo se crea y qué significa, realmente, “saber programar”.

Conclusión

Celebrar hoy el Día de la Informática es mucho más que recordar una fecha en el calendario. Es reconocer una de las fuerzas más silenciosas y, al mismo tiempo, más decisivas de nuestra época. La informática no solo ha cambiado las herramientas que usamos, sino también la manera en que pensamos, nos comunicamos, trabajamos y entendemos el mundo. Forma parte de nuestra intimidad cotidiana, incluso cuando no somos plenamente conscientes de su presencia. Y, cada vez más, también está llamada a ser una aliada clave en los grandes retos de nuestro tiempo, desde la eficiencia energética hasta la sostenibilidad de los sistemas, las ciudades y los modelos de consumo.

Detrás de cada aplicación que usamos, de cada mensaje que enviamos, de cada sistema que funciona sin que lo notemos, hay personas que construyen lo invisible: quienes diseñan, programan, mantienen, investigan y mejoran día a día la infraestructura digital que sostiene nuestra vida moderna. Este día es también una forma de agradecer ese trabajo silencioso, técnico y creativo que rara vez ocupa titulares, pero sin el cual todo se detendría. Informáticos e informáticas del mundo, gracias.

Y, quizá, la pregunta más importante no es solo qué ha hecho la informática por nosotros, sino qué estamos construyendo ahora con ella. Las decisiones que tomamos hoy sobre datos, inteligencia artificial, automatización, educación tecnológica o ética digital están dando forma al mundo en el que viviremos mañana. El futuro no llegará de repente: se está programando, línea a línea, en el presente.

Por eso, el Día de la Informática no es solo una celebración del pasado, sino una invitación a mirar hacia adelante con responsabilidad, conciencia y visión. Porque aquello que hoy parece invisible, mañana será estructural. Y aquello que hoy estamos creando, será el entorno en el que vivan las próximas generaciones.

¿Qué papel quieres tener tú en el mundo digital que estamos construyendo?

Fuentes: